|

|

リアルタイムエアェクトは必要か?

今後のノンリニア編集システムの動向はズバリ,エフェクトのリアルタイム化と非圧縮を利用した映像の高画質化にあると言って間違いない。

|

|

■パソコンのノンリニア編集システムはレンダリング時間が必要だった

エフェクトのリアルタイム化は,ビデオ映像のプロにとっては,非常に重要な意味合いを持っている。

ポストプロダクションなどでテープベースのリニア編集システムを利用する場合,ワイプ*,デイゾルプ*,テロップ,2次元や3次元のDVE*(3次元のDVEはスタジオによっては無いところもある)などは,スタジオ内に組み込まれた装置によってリアルタイム処理ができるのが一般的だ。

ところが,パソコンのノンリニア編集システムで,映像間のワイプやテロップ入れ,DVE処理を行う場合にはパソコンのCPUにエフェクト処理の計算をさせなければならないので,必ずレンダリング時間が必要になる。これはどんな簡単なものであっても避けて通れない。

一般的なパソコンを使用して1秒間のディゾルブ/ワイプのようなエフェクトを計算させると約数十秒くらいのレンダリング時間を必要とする。これでは,テロップ入れなど長時間の挿入を必要とする場合は,かなりのレンダリング時間を要してしまう。しかも,できたものが気に入らなければ再度やり直しということになり,さらに長い時間が必要になる。

テープを使った従来のビデオ編集に慣れている人にとっては,このレンダリング時間は実に耐え難い苦痛の一つと言って間違いない。エフェクトのレンダリングが終わるのを待っている間に,演出上のひらめきやノリを悪くする場合もあり得るだろう。

これを解決するためにちょっと前に登場したのが,DSP(デジタルシグナルプロセッサ)チップを搭載して,ハードウエアでレンダリングを高速化するビデオキャプチャ再生ボードだ。Pinnacleの「Targa1000」や「Targa2000」シリーズ,Media100社の「Media100」シリーズがこれにあたる。これらは,リアルタイムではないものの,ハードウエアに付属する専用のエフェクト・プラグインを使用することで劇的にレンダリング時間を短くすることができる。

例えば,1秒間に約60秒かかるディゾルプも8〜15秒くらいで処理することができる。一般的にデイゾルプやワイブ処理は1〜2秒程度が普通だろうから,これくらいの時間だとレンデリングの待ち時間としてはそんなに苦にならないだろう。

|

図B●Boris Effectsを使ったDVE例

図C●PremiereのプラグインBoris Effectsの操作画面

|

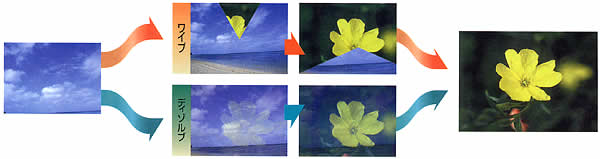

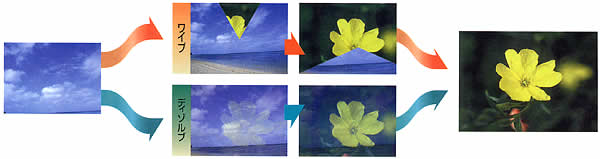

図A●ワイプとディゾルブ |

|

*ワイプ:前の画像から次の画像への切り替え(トランジション)を,画像を切りながら行うトランジション効果(図A)。違う場面への場面展開時に使用される。

*ディゾルブ:前の画像から次の画像への切り替えを,画像をOL(オーバーラップ)させながら行うトランジション効架(図A)。回想シーンなど,前の場面を引きずりながら次の場面へ切り替えるときに使用される。

*DVE(デジタルビデオエフェクト):アナログ編集(テープ編集)が主流だった頃,デジタルで行うビデオエフェクトをDVEと呼んだ。ノンリニア編集においても,画像の中にさらに多くの映像をエフェクト効果を付けながら挿入する処理をDVEと呼ぶ(図B)。プラグインソフトBorisEffects(図C)はその代表格。

|

|

■低価格でリアルタイムエフェクトが可能に

そして,間近になって登場し始めたのが冒頭で述べたリアルタイムエフェクトが可能なノンリニア編集システムやビデオキャプチャ再生ボードだ。もちろん,ハイエンド向けのノンリニア編集システムでは以前からいくつかの製品が存在していたが,最近ではかなり低価格の製品が登場してきている。

リアルタイム処理できるエフェクトの数は編集ソフトによって違ってくるが,通常よく使うディゾルブやワイブがリアルタイム処理できるだけでも作業時間をかなり短縮することができるはずだ。

しかし,作業時間を短縮できる理由は,エフェクトのリアルタイム化だけではない。 実はこれらの製品に使用されているビデオキャプチャ再生ボードは,「デュアルストリーム」に対応しているのだ。つまり,2つのビデオトラックを同時に再生することができるのである。このため,エフェクト処理をしながらすぐにビデオ出力することができる。つまり,無駄なムービーファイルを作る必要がないのである。これはハードディスクの節約にもつながる。

ただしテロップに関しては,使用する編集ソフトによりリアルタイム処理ができるものとリアルタイム処理ができないものがあるので注意が必要だ。概してノンリニア編集システムの専用ソフトや高価な編集ソフトには,テロップをリアルタイム出力できるものが多い。しかし仮にできない場合でも,「Inscriber

CG」などのテロップソフト(海外では一般にCG=キャラクタ・ジェネレータと呼ぶ)を使用すれば,リアルタイムテロップも可能となる。

|

|

■リアルタイムエフェクトは本当に必要か?

エフェクトのリアルタイム化は本当に必要なのだろうか?。

もちろん,システムに十分な予算が組める人は,リアルタイムエフェクトのできるマシンを買うに越したことはない。しかし,コストパフォーマンスを考えるなら,これからどのような目的で使用するかを十分見極めてから決めた方がよいだろう。

例えば,尺の短い映像編集を行う場合や編集より画像合成の方を主に行う場合なら,リアルタイムエフェクトはそんなに必要ない。リアルタイムエフェクトは通常ビデオサイズまでしか対応していないので,フィルムなどビデオサイズ以上で使用する場合も意味をなさない。しかし,こういう人でもたまにはビデオの編集をやることもあるだろう。こうしたケースではDSPチップを搭載したビデオキャプチャ再生ボードでレンダリングをアクセラレートした方がコストパフォーマンスはいいだろう。これならテレビサイズの解像度に限らずアクセラレートが可能だ。いずれにせよ,どういう目的で使用するかがシステム選択のキーとなるはずだ。

|

|

■OpenGLでエフェクトを高速化するアプローチもある

ところで,エフェクトのハードウエアアクセラレートが可能なボードとしては,ビデオキャプチャ再生ボードにDSPチップを乗せたもののほかに,専用のアクセラレートボードや汎用のアクセラレートボードも存在する。

例えば,DPSの「PerceptionVR」の場合専用のPerceptionF/Xボードを用いてアクセラレートできる。

また,汎用で使える「IceFX」(http://www.iced.com)は「AfterEffects」などのエフェクトをハードウエアアクセラレートできる。このボードを使用すると,複雑なエフェクトも高速化できる。

最近ではインターグラフのRender GLのように,OpenGLボードを使って2次元画像をアクセラレートする新しいアプローチも登場している。

OpenGLは,3次元CGソフトなどでモニター上の表示を高速化させるために開発されたもので,シェーディングやテクスチヤマッピング,バンプマッピングなどをリアルタイムに表示できる。しかし,表示だけではもったいないということで,この性能をCGの最終画像のレンダリングにも利用しようというのがRender

GLの考えだ。レンダリングの質感を上げるためにOpenGLの扱える項目を拡張している。

このRenderGLを使ってノンリニア編集のエフェクト処理をしようというのがインターグラフの新しいアプローチだ。RenderGL対応のプラグイン・フィルタViZfxを利用する。

|

| Q&A |

|

Q

僕は今,実写とCGの合成(動画)を制作しビデオに出力したいのですが.合成のやり方がよくわかりません。非常に恥ずかしい質問なんですがなせ人を映す時に背景をブルーにするのですか?合成方法などできれば教えて下さい。

A

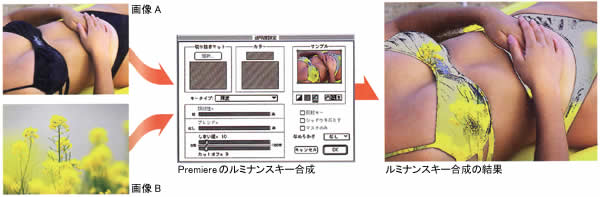

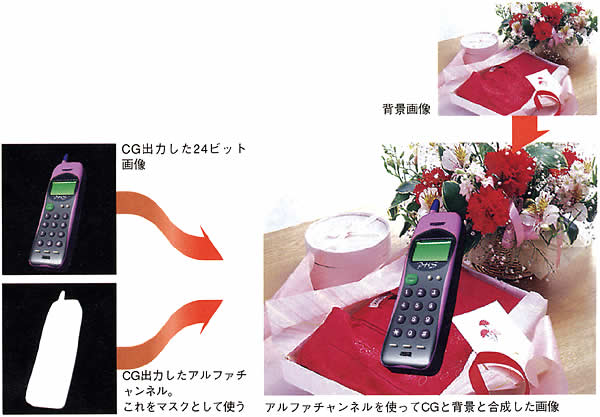

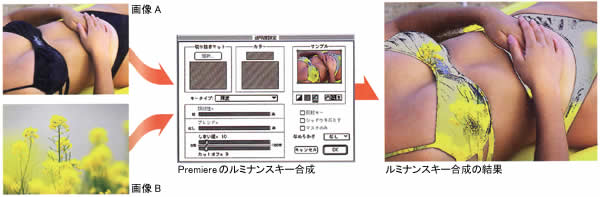

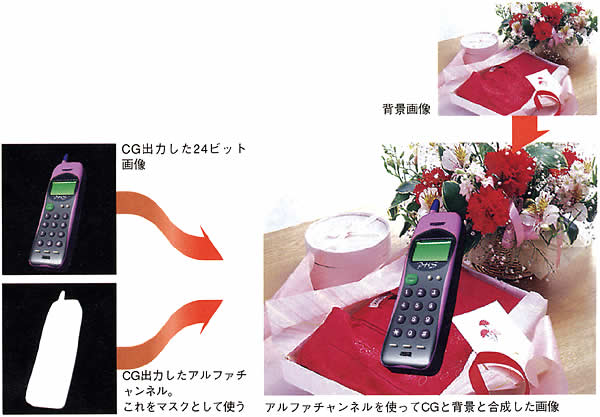

合成には、キーで抜く方法とマスクで切る方法(図D)があります。

キーにはクロマキーやルミナンスキーなどがあります。クロマキー合成とほ映像の色の情報を含むクロマ信号(Chrominance)のうちのある色信号を指定してその信号のみを抜く方法(図E)。ルミナンス合成とは映像の輝度とコントラストの情報を含むルミナンス信号(Luminance)のうちのある輝度信号を指定してその信号以下または以上のみを抜く方法です(図F)。

通常,クロマキーでブルーバックを用いるのは,人の皮膚にはブルー色素がほとんどないため皮膚を誤って抜くことがないためです。しかし、この場合ブルーの服を着ていると服まで抜けてしまいます。そのようなときはグリーンバックを用いる場合もあります。いずれにせよ,バックが均一になるように光を当てておかないときれいに抜くのは難しくなります。AfterEffectsなどの合成専用ソフトを使うとマスクとの供用でかなりのところまで追い込むことができます。

背買の映像の上に,CGを合成する場合は,CGのマスクを作ります。このマスクを使って静止画のは背景部分を抜くと合成が完了します(図G)。

CGを合成する場合はレンダリングするフォーマットに,32ビットのアルファチャンネルを持った画像データ(TargaやPhotoshopのPDSなど)に保存するか,24bitの画像と8bitのアルファチャンネルを別々に保存します。このアルファチャンネルが先程のマスクに相当しますので,このアルファチャンネルを使ってCGの周りの背景画像を抜き合成します。

合成するものが人や動物などの場合,一枚ずつマスクを撮っていくことも可能ですが,キーで抜く方法を用いると一回の指定でその色を抜くことができます。そのとき先にも言ったように,均一なバックカラーになるように撮影しておきます。

|

図D●マスク合成 |

図E●クロマキー合成 |

図F●ルミナンスキー合成 |

図G●背景とCGの合成 |

|

Q

ハードディスクの選択で悩んでおります。外付けでアレイを組むか内蔵でやろうと思っています。SeagateのCheetahが最速と聞いたのでCheetahを入れたいのですが,店の人に「熱の問題で内蔵はとても無理,外付けしか駄目でしょう」と言われました。

DOS/Vショップに売っているような外付けのワイド対応ディスクケースに冷却ファンをつけて,Cheetah2台組みのアレイシステムを組めるものでしょうか?それとも,熱に強いアレイ専用のケースが必要になってくるのでしょうか?

作品のイメージ品質はできる限り良いものにしたいので速いハードディスクが欲しいのですが,Cheetahでなくても大丈夫ですか?

A

SeagateのCheetah(Ultra Wide SCSI)は回転数10000rpm,シークタイム8msec,転送レート11.3〜16.8MB/秒のスペックを持つ非常に高速なハードディスクです。最近ではUltra2

Wide SCSlインタフェースを持ったものも発売されており,転送レートほ14.5〜21.8MB/秒にも達しています。1台でこの数字は,一昔前なら考えられません。ハードディスクのスペックはメーカーのWebで調べることができます(Seagateはhttp://www.seagate.com)。

筆者はUltra Wide SCSlタイプのCheetah(ST19101W)をPerception VR用に使っています。パフォーマンステストでは9.5MB/秒をクリアしています。つまり.2台でアレイを組まなくてもこれくらいの転送レートの範囲なら十分使うことわ可能だということです。

今後さらに低圧縮のシステムを組む予定があるようでしたらそのときに2台でアレイ接続すればよいのではないでしょうか。Cheetahは実際のところかなり発熱しますので、自作の場合きちんとした空冷処置か必要になります。ただ単に空冷ファンを付けただけではダメです。ハードディスクの正面から風を入れ,後ろに流れていくように工夫して下さい。もちろん,これらの作業ほ自分で責任を持って行って下さい。発熱を気にするようでしたら,7200rpmのBaracudaシリーズ2台でアレイを組む方法もあるかもしれません。

ちなみにSCSIのタイプにはNarrow,Ultra,Wide,Ultra Wide,Ultra2 Wideが存在し、データを流せる最大値はそれぞれ10MB/秒,20MB/秒,20MB/秒,40MB/秒、80MB/秒となっています。これは,アレイを組んだ場合も変わりません。上位互換ですから混在は可能ですが,混在させた場合一番下のスペックになります。接続端子はNarrow,UltraはNarrowタイプで,ほかはWideタイプです。

|

|

| |

[次のページへ] |

| ノンリニアビデオ編集完全ガイド2000 |